지난번 글에 이어서 오늘은 Meta의 라마 3.1(llama 3.1)과 터미널에서 대화는 것 이외 챗GPT와 비슷하게 WebUI를 이용하여 편리하게 대화할 수 있는 환경 설정에 대해 살펴보겠습니다.

llama 3.1을 위한 Open WebUI (Docker)

지난번에 이어진 내용이므로 이미 라마 3.1은 설치되었다고 가정하고 진행합니다. 혹시 라마 3.1 설치부터 진행해야 한다면 아래 링크의 글을 따라 설치를 먼저 진행한 후 이 글을 참고해 주세요.

Meta AI의 Llama3.1 다운로드 및 설치 방법 그리고 WebUI 1of2

Meta AI의 Llama3.1 다운로드 및 설치 방법 그리고 WebUI 1of2

오늘 라마 3.1(Llama3.1)을 직접 설치해 보고 앞으로 계속 사용해야 하므로 환경 설정을 어떻게 해야 조금 더 편리하게 사용할지 한번 준비해 보도록 하겠습니다. 지난 7월 23일(현지시각) 과거 페이

paulsmedia.tistory.com

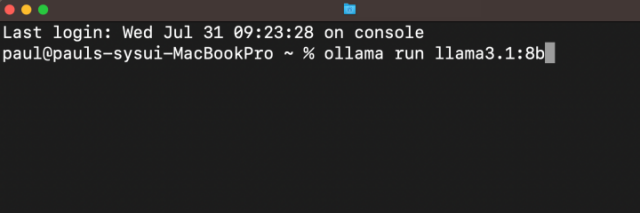

일단 다시 라마 3.1을 실행하여 대화를 해 보죠.

터미널을 열고 아래와 같이 command를 입력합니다.

ollama run llama3.1:8b

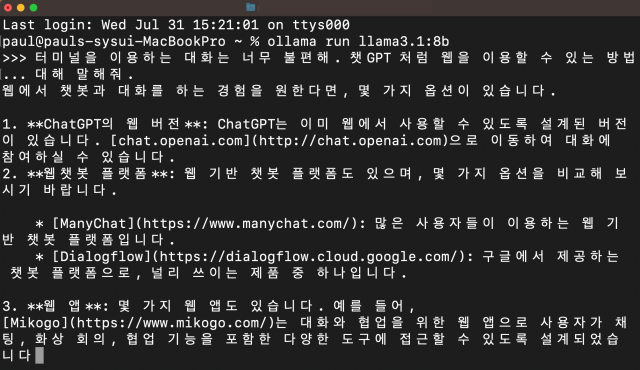

라마 3.1을 실행한 후 다음과 같이 메시지를 입력해 봅니다.

터미널을 이용하는 대화는 너무 불편해. 챗GPT처럼 웹을 이용할 수 있는 방법에 대해 말해줘.

위와 같은 요청에 아래 그림과 같은 조금은 엉뚱하지만 한번 확인해 볼만한 대답을 합니다. 하지만, 이번에는 이미 알고 있는 Open WebUI 방법을 사용할 것이므로 이 내용에 대한 검토는 넘어갑니다. 하지만 무엇보다, 역시 터미널을 이용하는 대화이므로 지난번 대화했던 내용을 한눈에 직관적으로 확인해 볼 수도 없고, 또 요청한 내용과 답변도 한눈에 구분하기 어렵운 모습니다.

우리가 원하는 것은 최소한 챗GPT의 웹 UI 방식이 터미널보다는 더 편하지 않을까 하는 생각에서 시작됩니다.

STEP 1. Docker 설치

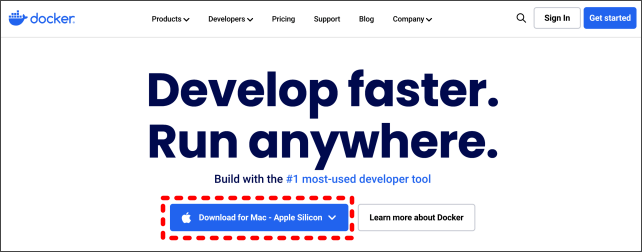

docker라는 Open WebUI가 있어요. openwebui에서도 Docker나 Kubernetes를 간편하게 설치하라고 하니까요.

Effortless Setup: Install seamlessly using Docker or Kubernetes (kubectl, kustomize or helm) for a hassle-free experience with support for both :ollama and :cuda tagged images.

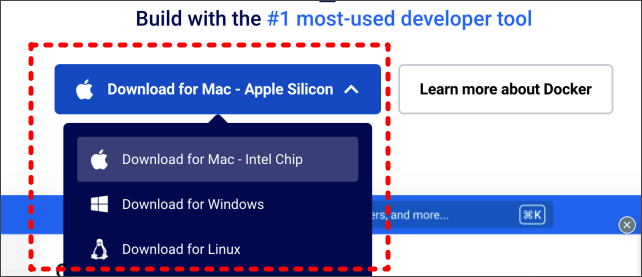

저는 Docker를 설치합니다. docker 홈페이지로 이동합니다.

맥북에서 접속했으므로 Download 옵션을 확인합니다.

저는 예전 맥북이므로 아래 그림과 같이 인텔칩 옵션으로 선택합니다.

이제 다운로드가 완료되고, 다운로드 디렉터리에 있는 "Docker.dmg" 파일을 실행합니다. Docker 아이콘을 우측으로 드레그 앤 드롭하여 설치를 시작합니다.

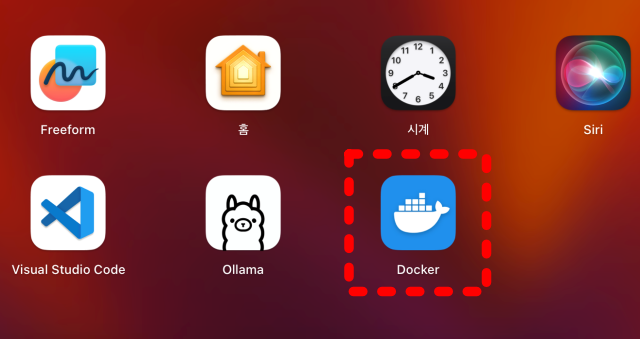

설치가 완료된 후 Launchpad (윈도우라면 바탕화면?)에 아래와 같이 Docker 아이콘이 보입니다.

STEP 2. Docker 환경 설정

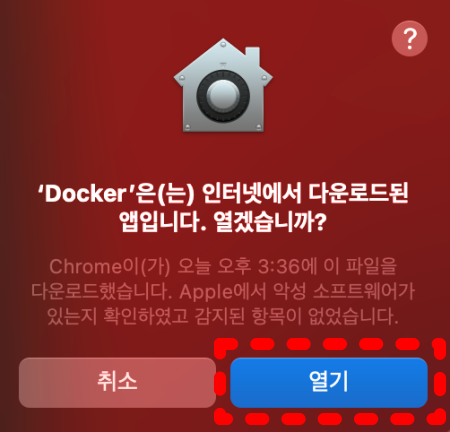

아이콘을 클릭해서 앱을 실행합니다. "열기"를 선택해서 앱을 실행합니다.

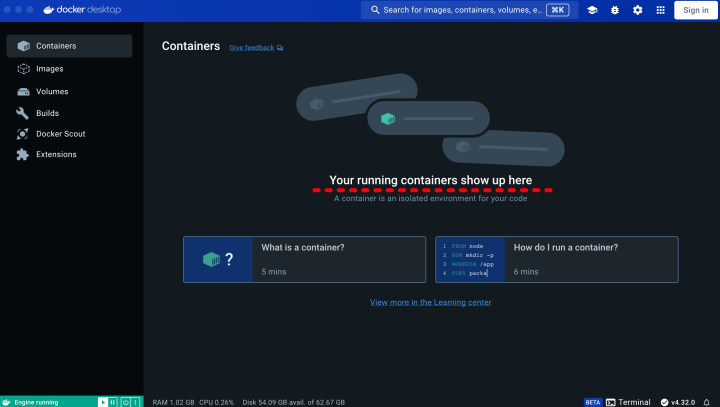

아래 같이 Docker앱이 실행됩니다. 처음 실행했으므로 실행 중인 컨테이너가 없습니다.

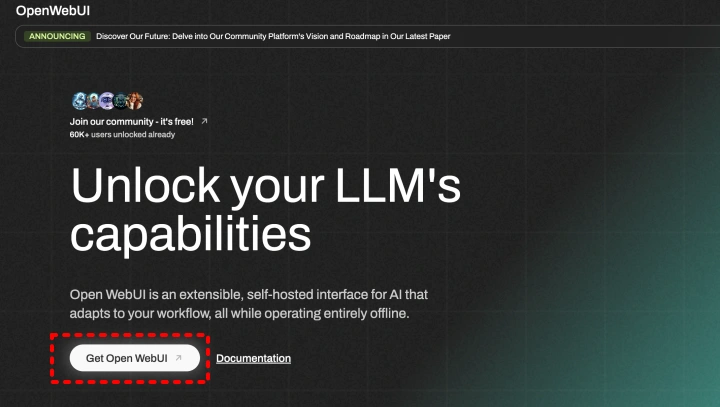

환경 조건에 맞는 컨테이너를 설정해야 하므로 Open WebUI 홈페이지로 이동합니다.

위 그림과 같이 홈페이지 화면이 나타나고 중간에 "Get Open WebUI"를 클릭하여 Open WebUI의 GitHub로 이동합니다.

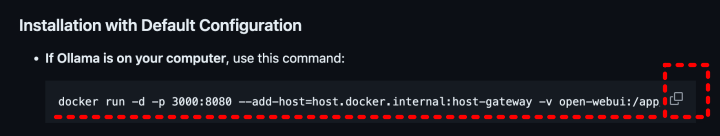

이동한 Github 페이지를 아래로 내리다 보면 다음 그림과 같은 부분이 나옵니다.

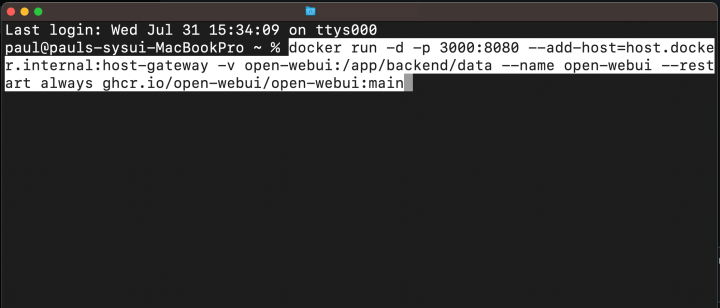

화면의 우측 copy 버튼을 클릭 하여 command 내용을 복사합니다. 터미널을 열고 복사한 command를 입력하여 실행합니다.

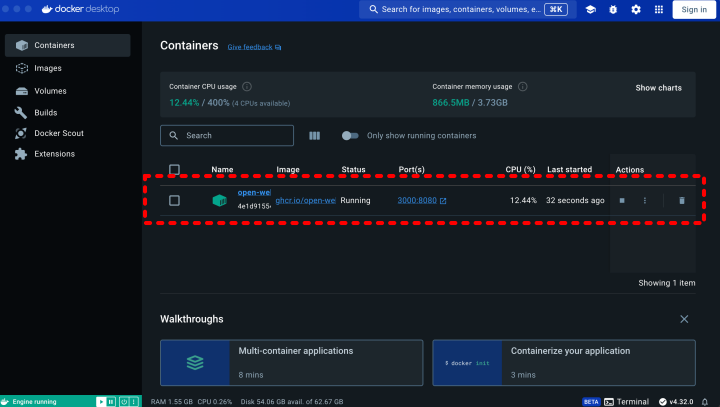

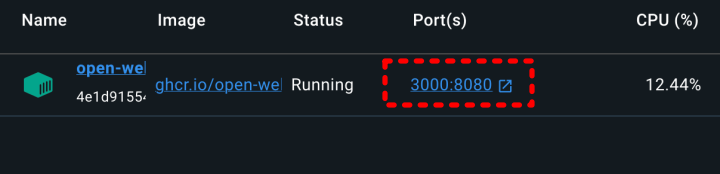

실행이 완료되고 나서 다시 Docker 창을 열어봅니다. 화면 중간에 실행 중인 컨테이너가 나타나 있습니다.

실행 중인 컨테이너의 중간 부분, 아래 그림과 같은 위치를 클릭합니다.

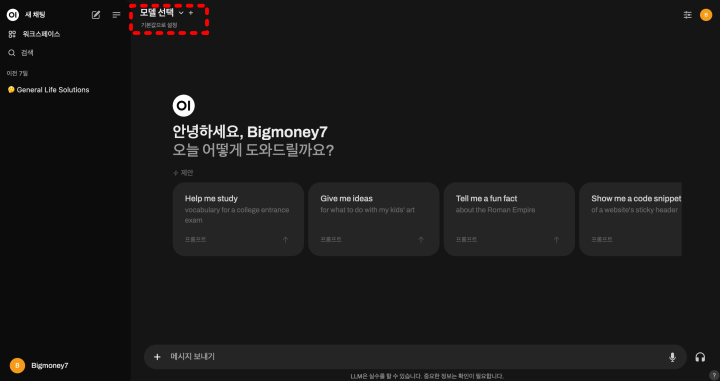

이제 아래와 같이 WebUI 화면이 열립니다.

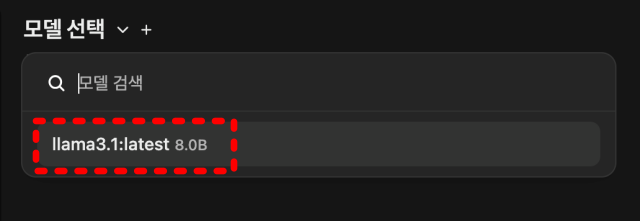

화면 상단에 "모델 선택" 부분을 클릭합니다. 아래와 같이 모델명을 선택합니다.

만일 모델명이 보이지 않으면 터미널에서 라마 3.1을 다시 실행해 주세요. ( 상단 그림 "Llama3.1 실행 01" 참조)

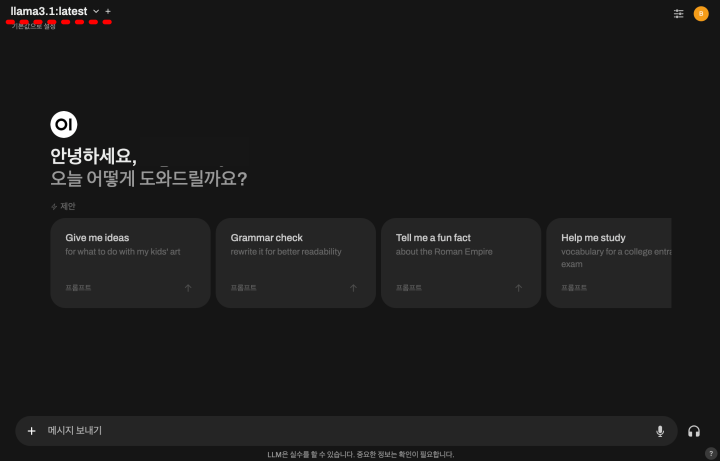

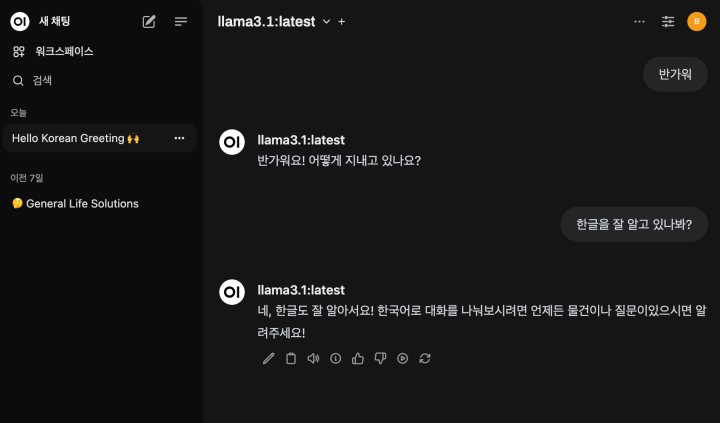

이제 UI 화면이 만들어졌어요. 라마와 대화가 잘 되는지 시도해 보겠습니다.

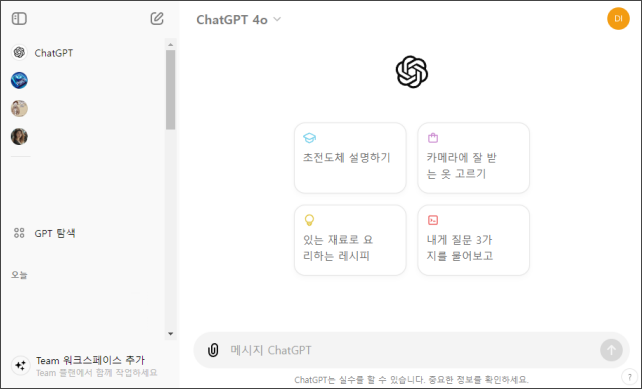

챗GPT의 화면과 상당히 유사합니다. 글도 직관적으로 잘 구분됩니다. 더구나 죄 측 부분을 보면 대화 기록이 있습니다. 저의 경우 7일 전 대화했던 기록도 보이네요.

자, 오늘은 라마 3.1 관련 두 번째 글로 WebUI까지 설정해 보았습니다. 다음 글에서 라마와 관련한 또 다른 주제로 이야기를 이어가 볼게요.