오늘 라마 3.1(Llama3.1)을 직접 설치해 보고 앞으로 계속 사용해야 하므로 환경 설정을 어떻게 해야 조금 더 편리하게 사용할지 한번 준비해 보도록 하겠습니다. 지난 7월 23일(현지시각) 과거 페이스북이었던 메타(META)에서 Llama3.1(라마 3.1)을 발표했어요. 과거 버전보다 더 높은 성능으로 우리에게 익숙한 챗GPT4와 성능을 견줄만하다고 합니다. 정말이지 최근 인공지능 그중 대화형 인공지능의 기술은 정말이지 매우 빠르게 발전하고 있는 것 같아요.

라마3.1(Llama3.1) 설치

우선 메타 다운로드 사이트에서 라마3.1을 직접 다운로드할 수 있습니다. 다운로드를 위해 이것저것 정보를 입력한 후 다운로드 하고 나면 설치하는데 또 이것저것 설정하고 맞춰줘야 합니다. 처음부터 직접 다 해보면 도움이 되겠지만, 먹을 때 빼고는 시간이 아까운 본인은 Ollama를 통해 설치하였습니다.

게으른 성격으로 Ollama를 선택했다고만 하기에는 좀 아까운 장점이 있는데요, 우선

- 편의성: Ollama는 설치 과정을 자동화하고 간소화하여 사용자들이 쉽게 접근할 수 있도록 합니다. 메타에서 직접 다운로드할 경우, 종종 많은 설정과 추가적인 설치 작업이 필요할 수 있습니다.

- 지원 및 유지보수: Ollama는 Llama 모델에 대한 지속적인 지원과 업데이트를 제공합니다. 이는 버그 수정이나 성능 향상 등의 혜택을 포함할 수 있습니다. 반면, 메타에서 직접 다운로드한 모델은 사용자 스스로 유지보수를 해야 할 수 있습니다.

- 커뮤니티 및 자료: Ollama는 사용자 커뮤니티와 자료가 풍부하여 다양한 튜토리얼, 문제 해결 방법 등을 쉽게 찾을 수 있습니다. 이는 사용자들이 더 쉽게 모델을 이해하고 활용할 수 있도록 도와줍니다.

- 호환성: Ollama는 다양한 플랫폼과 호환성을 제공하여 모델을 다양한 환경에서 사용할 수 있도록 지원합니다. 이는 특히 다양한 운영 체제나 환경에서 작업해야 하는 사용자들에게 큰 장점이 될 수 있습니다.

- 추가 기능: Ollama는 기본 모델 외에도 추가적인 기능이나 툴을 제공할 수 있습니다. 예를 들어, 모델의 최적화나 특정 작업에 맞춘 설정 등을 제공할 수 있습니다.

자, 그럼 시작해 볼께요!

STEP 1. Ollama 설치

Ollama

Get up and running with large language models.

ollama.com

ollama 사이트에 들어가면 첫 화면이 위 그림과 같습니다. 바로 ''Download' 버튼을 눌러주세요.

OS를 선택하는 화면이 나옵니다. 저는 2019년형 맥북 프로에 설치합니다. 옛날 버전 맥북으로 요즘 것들과 비교하면 상당히 느리죠. 과연 얼마나 느릴지 한번 확인해 보겠습니다.

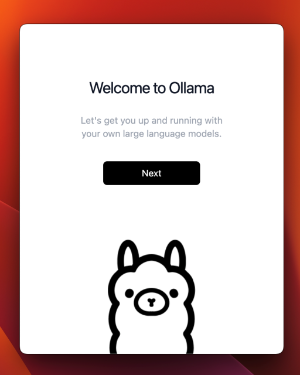

파일 다운로드를 완료하고 설치를 시작하면 아래와 같은 화면이 나옵니다.

환영한다니 반가운 마음으로 "Next"를 클릭해 줍니다.

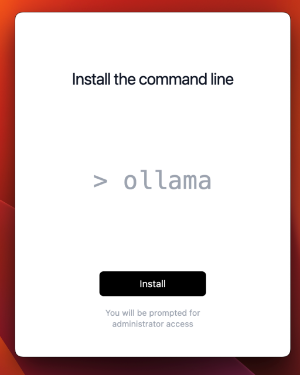

"Install"을 선택해서 설치를 진행합니다. 이제 설치가 완료되고 아래와 같은 화면이 나옵니다.

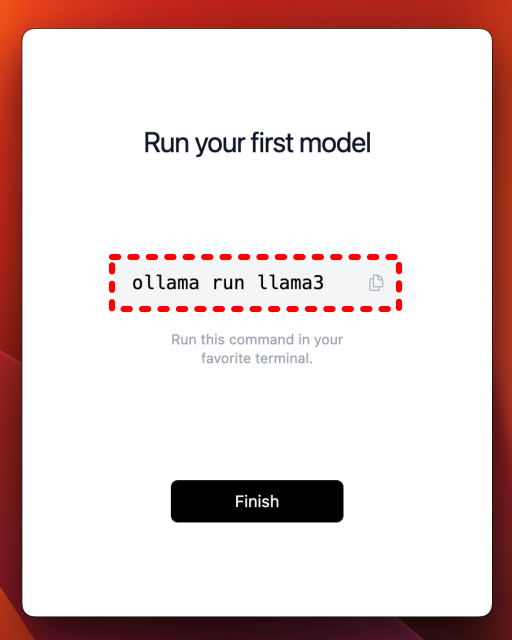

터미널을 열고 "ollama run llama3"를 입력해서 라마를 설치하라고 합니다. 여기서 중요한 것은 최신 버전을 확인해 봐야 합니다.

STEP 2. 라마 설치

ollama 사이트에서 오른쪽 상단의 "Models" 메뉴를 선택합니다. (직접 가기: https://ollama.com/library)

현재 최신 모델은 "llama3.1"입니다.

llama3.1을 선택해서 다운로드할 세부 버전을 확인합니다.

405b 버전은 231기가바이트, 70b는 40기가, 8b는 4.7기가라고 합니다. 맥북에 설치할 것으므로 가장 작은 버전을 선택합니다. 마음 같아서는 405b를 선택해서 정말 챗GPT-4와 비슷한 성능을 내는지 확인해 보고 싶지만, 405b를 실행하려면 개인용 PC에서는 메모리가 턱없이 부족할 것 같습니다. 어쩔 수 없이 8b를 선택합니다.

라마 버전을 확인합니다. "ollama run llama3.1:8 b"

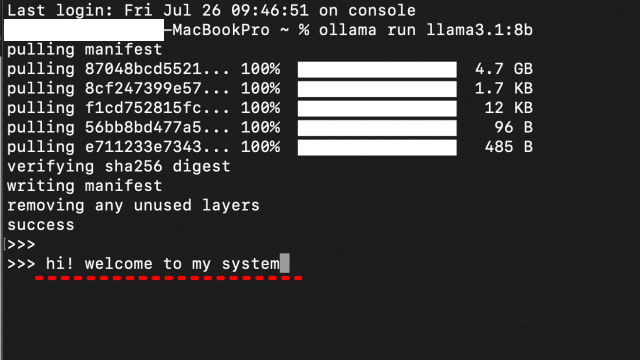

터미널을 열고 위에서 확인한 버전을 입력하여 라마를 설치합니다.

8b는 용량이 적어서인지 다운로드 및 설치에 오래 걸리지 않았습니다. 설치가 완료되면 메시지를 입력하라며 커서가 깜빡입니다. 바로 환영한다는 메시지를 입력해 봤습니다.

대답은 아래와 같습니다.

자, 라마 3.1 설치가 끝났습니다. 간단한 대화도 확인했고요. 인텔 버전 맥북에 설치해서 그런지 챗GPT4와 비교하면 말도 안 되게 느립니다. 물론 버퍼링 걸리 듯 속 터지게 느린 건 아니고요, 좀 느리구나 싶은 정도입니다. 대화가 불가능하거나 그런 건 아닙니다. 또, 4.7기가바이트짜리 소형 버전임에도 불구하고 상당히 똘똘합니다. 한글도 이 용량에 이 정도면 잘한다 싶습니다.

그럼에도 뭔가 터미널에서 대화를 한다는 것이 불편합니다. 그럼 다음 글에서 터미널을 떠나보내고, 챗GPT처럼 웹페이지를 이용해서 라마 3.1과 대화하는 방법에 대해 정리해 보겠습니다.